嘿瞧瞧这AI发展的速度数字人DigitalHumans这玩意儿如今可是越来越成熟了 再加上能以极低的成本迅速生成。为啥这么受大家关注呢?并且还不是因为他那广泛的商业应用场景嘛!你考虑考虑不管是虚拟现实VR增强现实AR这些高科技领域依旧影视制作游戏开发品牌宣传这些传统行业 数字人可都扮演着举足轻重的角色呢!

从基本上来说数字人那就是五花八门有3D建模并且还包含动作捕捉的数字人有静态2D形象的数字人这里面并且还有别的真人的元素呢 另外那种真人换脸类的数字人。这分类可真是够细致的!

咱今儿个基本上聊聊个人形象克隆形象类的数字人 这玩意儿属于静态2D形象数字人。他有三个基本功能点那就是真人形象语音克隆口型同步。你考虑考虑这功能得多强大啊!

不过呢有些项目里可不包含语音生成克隆这部分但这实际上也不是啥重点你行单独去部署嘛。市场上那些优秀的AI语音克隆项目多了去了随便挑一个都可以用这有啥难的?

再说说2D静态数字人的质量吧 现在差异基本上在哪儿呢?就重点在于口型同步并且还有别的视频动作自不自然。你考虑考虑假如口型对不上动作又僵硬那数字人得多别扭啊!所以你可以做到试着单独优化口型同步节点 说不定能有意想不到的效果呢!

除此之外啊换脸克隆声音也是快速生成数字人的一个方法 特别是适合维持公共发言人形象声音不变的情况。但这方法可不包含在咱接下来的方案里哦。为啥呢?因为先进的视频换脸技术普及后那就是在风险的咱可不能轻易尝试!

再来说说这咱得提提AIGCPanel:开源克隆数字人整合系统 一键部署免费数字人客户端。这系统可真是绝了!他是一款面向所有用户的一站式AI数字人制作系统使用electronvue3typescript技术栈开发可以让Windows系统一键部署。你说方便不方便?系统设计得特别是用户友好不管你是个技术小白同样可以轻松上手!

这系统基本上功能可不少视频数字人合成语音合成语音克隆等等样样俱全。并且还有别的他并且还给了完善的本地模型管理功能 可以让你用起来更加得心应手。更屌的是系统可以让多语言界面包含简体中文和英语并且还集成了MuseTalkcosyvoice等多个成熟模型的一键启动包。你考虑考虑这功能得多强大啊!

特别是是视频合成方面 他可以让视频画面和声音的换口型匹配技术 这技术可真是够先进的!语音合成方面呢也提供了丰富的声音参数设置选项 可以让你想怎么调就怎么调。此外身为一个开源项目AigcPanel基于AGPL3.0协议发布并且还特别是强调合规使用 明确禁止用于任何违法违规业务。这可真是个有良心的项目啊!

不过你有没有想过这数字人技术虽然强大 但假设被别有用心的人利用那后果可不堪设想啊!所以啊咱在享受技术带来的便利的同时间也得时刻保持警惕别让他成了坏人的帮凶!这观点有没有挺反常识的?但仔细想想并且还真有那么点道理呢!

DUIX:实时互动的智能数字人 可以让多平台一键部署.

DUIXDialogueUserInterfaceSystem是硅基智能开发的由AI驱动的数字人交互平台. 开源的数字人互动功能让开发者能轻松集成大规模模型ASR和TTS功能实现和数字人的实时对话. DUIX可在Android和iOS等平台上快速部署 每个开发者无所谓轻松创建符合个性化要求的智能数字人助手 并将其应用到各个行业.平台部署成本低网络需求小功能丰富能满足视频媒体客户服务金融广播电视等多个领域的需求.

音频驱动的动态肖像合成:EchoMimic技术框架

蚂蚁集团终端技术团队研发的EchoMimic项目提出了基于可编辑标志点的音频视觉映射方法。该框架办成建立音频特征并且还有面部运动参数之间的关联模型 实现了高保真度的肖像动画合成。不同于传统方法该系统使用多模态特征融合策略 在公开标准测试集上的实验表明 其生成的动态序列在运动自然度和时序连贯性方面均呈现非常明显优势。

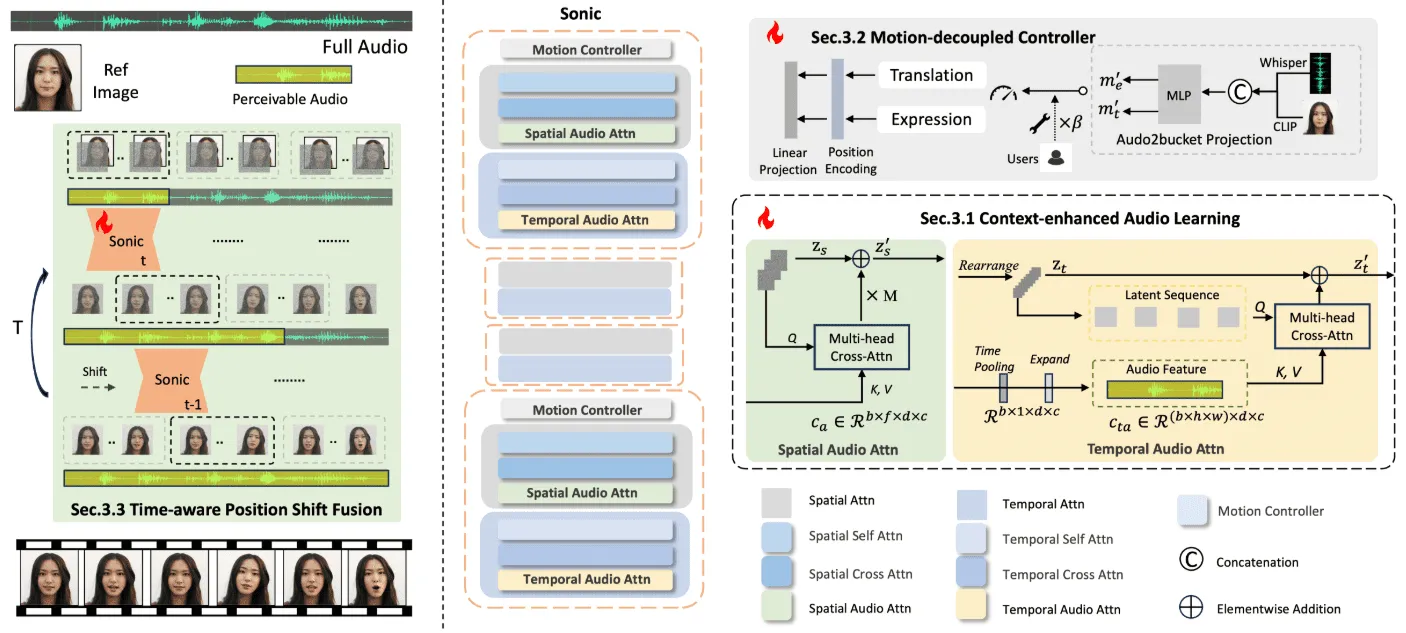

多模态表情合成:Sonic平台架构解析

由腾讯浙江大学联合团队开发的Sonic系统建立了音频到面部运动的端到端生成模型。该平台创新性地引入时域感知玩法 走通分层特征提取将音频信号分解为不一起间尺度的运动参数。实验验证表明该系统具备跨风格适配能力 可在针对不同艺术风格的输入图像保持稳定的运动生成质量 在长序列渲染任务中展现出较好的时序一致性。

>思考中….

Hallo2音频驱动生成口型/表情同步的肖像视频含Windows一键安装

这么说吧Hallo2这东西简直神了。你给他一段音频他就能给你捣鼓出一个高分辨率的人像动画口型表情跟音频那是严丝合缝。这背后是复旦大学和百度两家技术大牛的联手 我第一次听说这项目的时候 并且还以为是啥小作坊产品结果一看背景嚯。他们把这项目开原开源了用的都是些尖端玩意儿比如生成对抗网络GAN和时间对齐技术。效果怎么样4K分辨率视频长度能达到一小时这在以前想都不敢想。更绝的是Hallo2并且还可以让你用文字去指挥视频想要啥样的内容多样性想怎么控制细节都在一定程度上实现这就很人性化了不是么…

VideoChat打造你专属的数字人声音形象可以定制并且还可以实时跟你唠嗑 管你是要一条龙语音服务仍旧分段处理他都行

VideoChat是个实时语音数字人项目绝对开源既能端到端处理语音GLM4Voice到THG也可以让传统级联方式ASRLLMTTSTHG。你能随意换数字人长相和声音 甚至可以说克隆特定音色 此外超棒的唇形同步效果。视频流输出快得惊人首包延迟只要3秒。想试试?直接上在线demo体验并且还是说按照文档在自己电脑上搭建玩玩。

TalkingAvatar:创建和编辑AI虚拟形象视频平台基于本地算力Windows客户端

TalkingAvatar绝对是AI虚拟形象界的佼佼者 给你提供从头到尾的数字人解决方案。他彻底改变了视频内容创作方式。背后的AI技术相当强悍可以让你轻轻松松重写视频复制任何声音让嘴型和声音完美匹配 此外可以做出你想要的任何视频效果。不管你是想给现有视频换个声音 依然从零开始讲个全新故事TalkingAvatar都可以搞定。

听我跟你讲最近我发现一个超级有料的玩意儿叫SadTalker。哎哟这东西真的不是盖的!

你想一下啊就是那种普普通通可能都有点看腻了的静态照片就一张!再配上一段事先录好的音频然后你猜怎么着?用SadTalker这么一”鼓捣”哗嚓!照片里的人并且还是说说那张脸蛋儿活了!立马儿开始张嘴说话。

我这说的可不是那种僵硬的 好像被提线木偶一样拉扯着嘴皮子动那么简单。人家那个同步率那个自然感绝了!嘴型跟音频配合得严丝合缝栩栩如生咧。就好像有人给这张冰冷的图片施了个魔法他就乖乖地听你指挥灵动起来了。讲真有时候乍一看那水准甚至可以说能小小地惊艳我一下。

你肯定好奇这是怎么实现的背后是啥黑科技吧?这SadTalker啊他骨子里用的是一套挺牛气冲天的3D建模技术比方说什么ExpNet啦PoseVAE啦虽然名字咱听着可能有点发懵但效果是实顶实的。他可不独盯着嘴巴怎么动那些像是眉毛的挑动脸部表情的细微变化说穿了说话时轻轻歪一下脑袋的小动作这类的”点睛之笔”都被他给拿捏得死死的。所以嘛出来的效果就特别是有人情味儿显得真实多了。就是那么回事儿!

这玩意儿能用在哪儿?那你可就有得想了…讲真脑洞有多大他的舞台就有多大!比方说啊:

整个独家定制的祝寿视频?弄张自家老人年轻时的照片来说话那感觉哇塞!

老师们拿他给教学课堂加特效?让那些教科书里的历史大佬亲自来讲课 那学生并且还不得眼都瞪圆了!

甚至可以说我看那些搞营销的鬼才们同样可以拿他搞点博眼球吸流量的酷炫玩法。

另外一点你知道吗?这类的玩法现在可是免费的 彻底能弄个时下流行的数字人出来跑任务这不香吗?

有关咱们这样的普通用户来说 特别是是喜欢捣鼓新鲜事儿的人 拿来制作各种趣味视频 并且还是说单纯就是把压箱底的老照片拿出来复活一下自娱自乐光是想想过程都觉得有意思透了对伐?

真的当我第一次成功让那些老照片里的人开口说话那感觉就好像…嘿不就像是偷偷摸摸瞄到了一点点未来科技的影子嘛!特带劲!

AniPortrait:实现音频驱动图片或视频来生成栩栩如生的数字人讲话视频

AniPortrait这个创新框架是依靠音频来生成逼真的肖像动画的。这项目是腾讯游戏知己实验室里的华为伟 杨泽俊和王志声三个人联手开发出来的。AniPortrait可以做到依据音频文件和一些参考肖像图像生成高质量的动画 况且他并且还可以可以让使用视频身为面部重现的数据源。由于用了先进的3D中间表达及2D面部动画技术手段 所以该框架可以产生既自然又连贯的动画效果 特别是适合用于电影电视剧制作 虚拟主播形象打造以及数字人的各种使用场景。

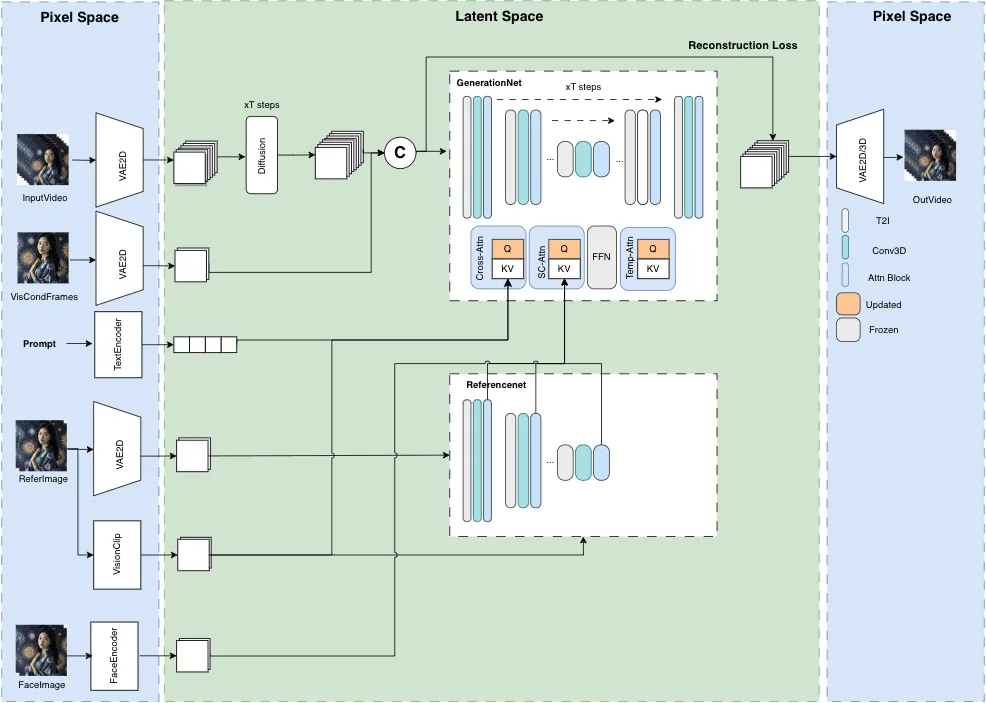

MuseVMuseTalk:适用于完整的数字人视频生成框架从人像到视频根据姿态生成视频进行唇形同步

MuseV项目是在GitHub上开放的大体上目的是因为要实现长时间段下的高保真度虚拟人视频的自动生成。他凭借于扩散技术除此之外拥有诸多功能比如从图像到视频的转变 走通文本描述生成图像然后再转化为视频另外啊直接利用现有视频片段生产新的影像等。除此之外并且还有别的提供了相当详细的模型设计思路阐述实际使用案例集锦初学者快速入门教程进行推理的具体脚本文件此外其他诸如致谢之类的信息。

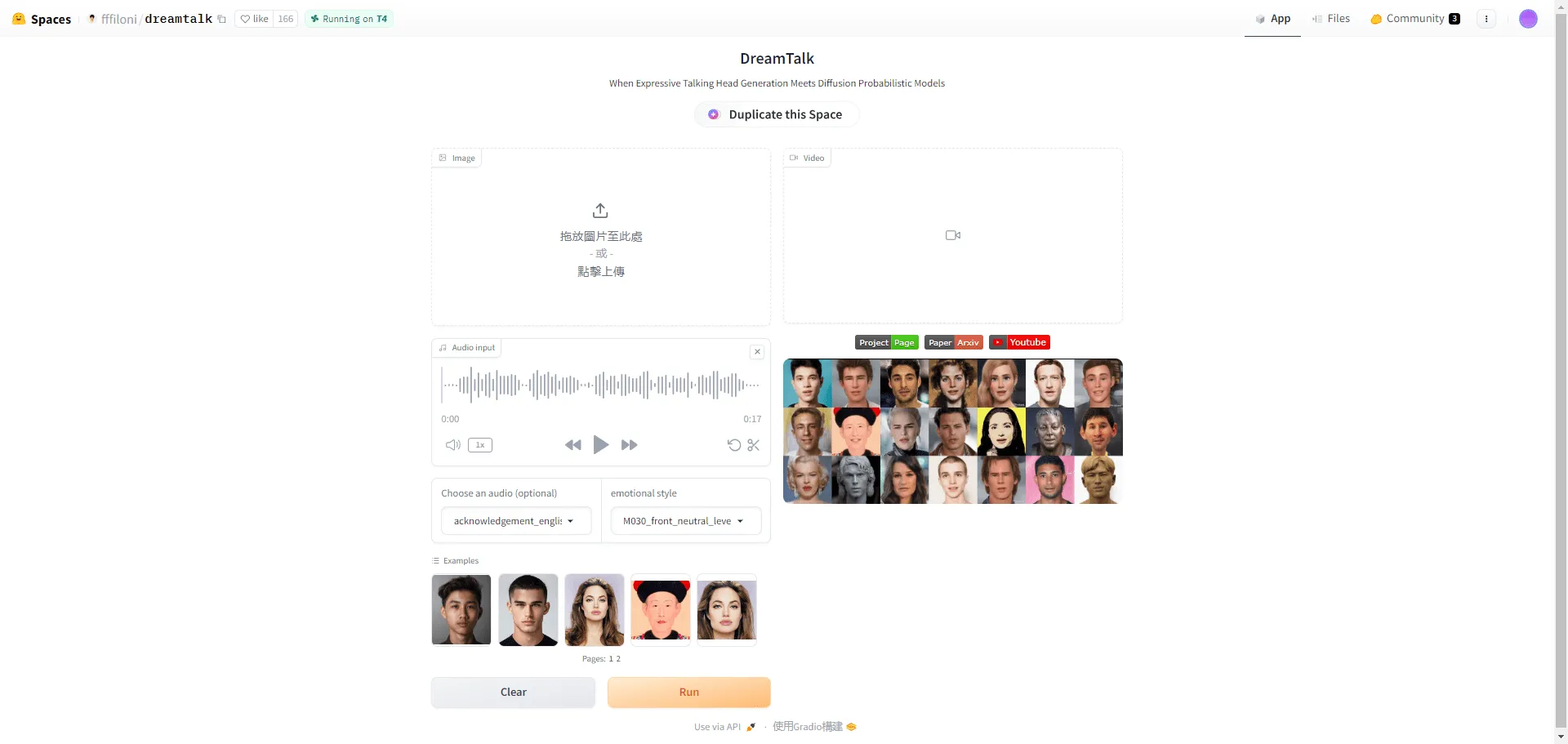

DreamTalk:只要一张头像就能造出活灵活现的说话视频

想象一下你只给系统一张脸部照片 接下来他就能根据你说的话精准地动嘴变表情听起来自然又生动这就是DreamTalk带给我们的体验。这款由清华阿里和华中科技大学合作打造的深度学习项目 背后依赖的是一种叫做扩散模型的先进技术。他的秘密武器包括但不限于降低噪声的网络大脑式嘴唇动作专家此外预测风格的智能分析器。他不但理解多国语言同样可以辨识嘈杂环境下的声音 确定生成出来的说话图像口型动作对得上音频真人感爆棚。比方说你在嘈杂的咖啡厅录音 他仍旧能让屏幕上的脸精准地跟着说话 这在远程会议或虚拟主播里特别是实用。

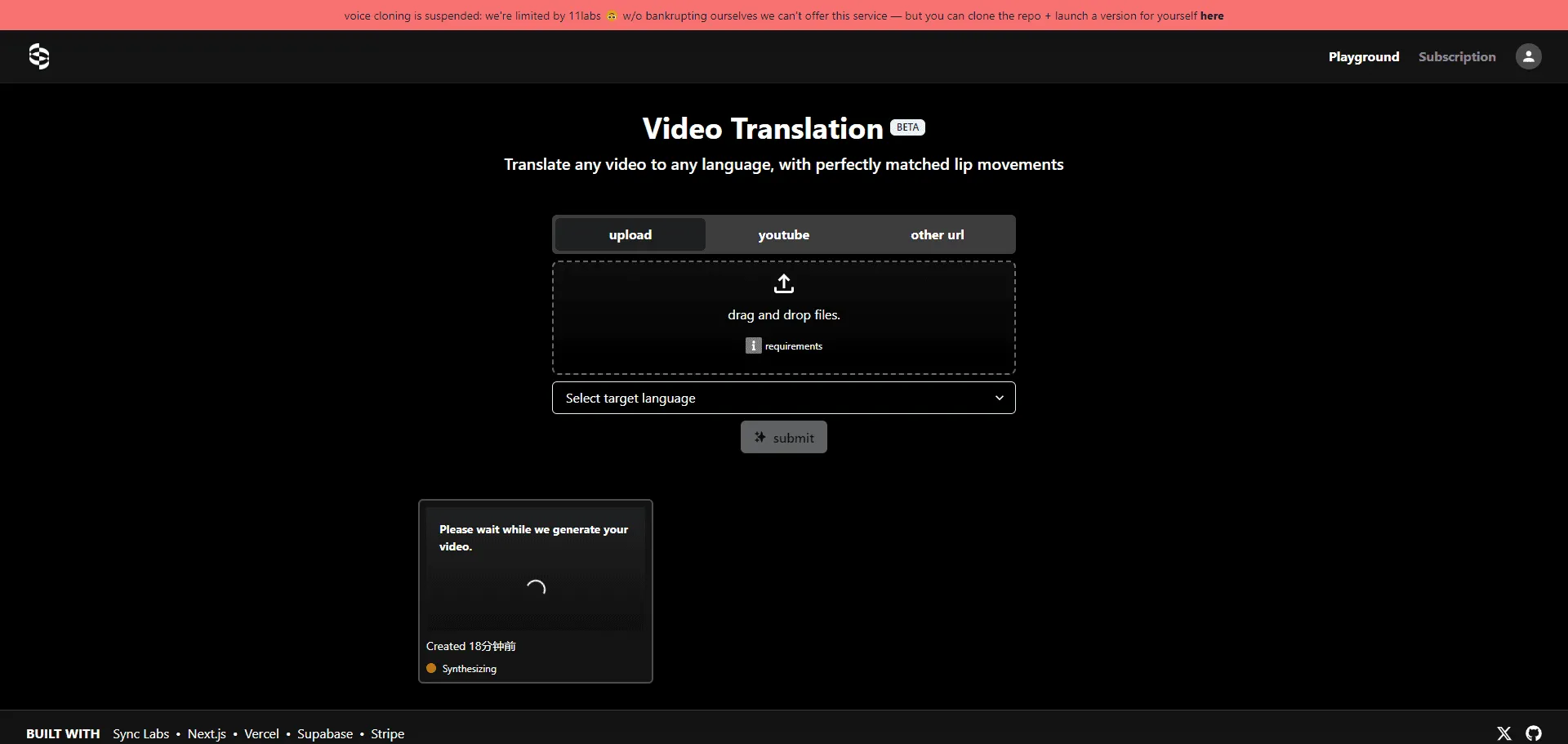

TranslationStarter:一款开源工具搞定视频翻译和嘴型配对

有没有想过视频里的说话内容一转码成别的语言嘴型却不对劲?这时你就需要像TranslationStarter这样子的帮手了。这个工具是SyncLabs弄出来的开源成果方便程序员迅速加入多语言的视频处理能力。他带有完善的接口和说明 让开发者无需从头研究就能把视频翻译和嘴唇同步点子多整合到产品中。他结合了SyncLabs独门的嘴型同步技术OpenAI近乎魔法般的Whisper翻译系统除此之外ElevenLabs人声生成算法。打个比方做一个跨国会议软件时TranslationStarter能帮你确保做到不同语言的音视频完美契合看着不违和就像看本地视频一样舒服。