在人工智能技术飞速发展的今天,智能客服已不再是新鲜事物。早在大型语言模型(LLM)概念普及之前,对话式AI就已经被广泛应用于客服场景,尤其是在电商等领域。我们或许都曾与那些能够回答简单、预设问题的机器人进行过互动,它们虽然解决了部分重复性工作,但其智能水平相对有限,难以应对复杂多变的用户需求。现在,借助以ChatGPT为代表的强大大型模型能力,我们如何才能构建一个真正基于企业私有数据、能够提供精准、个性化服务的专属ai智能客服机器人呢?

初期探索:直接通过Prompt喂数据是否可行?

对于企业而言,无论是面向终端C端用户还是企业B端客户,售前咨询环节总是伴随着大量重复性的问题,例如产品特性、优势、价格、技术部署、售后政策等等。人工客服需要耗费大量的精力去维护和解答这些标准化的咨询。自然而然地,许多人会想到利用大型语言模型来自动化这一过程。最直观且实现门槛较低的想法便是:将我们企业的产品资料、销售手册、常见问题集(FAQ)等私有数据直接作为Prompt的一部分,连同用户的具体问题一起发送给大模型,然后让模型基于这些信息来生成回答。

这种直接将参考资料“喂”给大模型的“笨方法”,在一些早期的实验或对简单场景的应用中,确实能够产生看似合理的回答,效果甚至可以说“还不错”。它的优势在于无需对模型进行复杂的训练或调整。然而,这种方式的局限性很快就会显现,尤其是在处理大量、复杂的企业知识时。

核心瓶颈:大型模型的Token限制及其应对之道

在使用大型语言模型处理企业级的复杂咨询时,一个突出的技术难题便是模型的上下文窗口限制,通常以Token数衡量。主流模型如GPT-3.5有4096个Token的限制(相当于约1.6万个英文字符或8千个汉字),而即使是更先进的模型,其上下文窗口也是有限的。这意味着如果我们将过多的信息(包括企业私有数据、用户问题和对话历史)一次性塞给模型,超出了其处理上限,模型就会开始“遗忘”先前的输入内容,导致回答变得不连贯、脱离上下文,甚至一本正经地给出错误信息——也就是我们常说的“胡说八道”现象。对于需要引用大量企业内部资料才能给出准确回复的专属ai智能客服而言,这一Token限制无疑是构建可靠系统的关键障碍。

这一问题曾困扰了许多开发者。幸运的是,针对这一难题,领先的模型提供商(例如OpenAI)提供了更为成熟和高效的解决方案,主要包括微调(Fine-tuning)和向量嵌入(Embeddings)两种策略,来帮助用户将自己的私有数据有效地集成到大模型的应用中。

这两种方法各有特点:

- 微调(Fine-tuning): 相当于在大型模型已有的庞大知识基础上,利用企业特定的高质量数据集(通常是问答对形式)进行二次训练。这会让模型更好地理解和生成与企业业务领域相关的、风格一致的内容。它适用于企业核心知识相对稳定、数据集规模适中、且追求模型输出风格或专业性深度优化的场景。微调的过程需要投入一定的训练成本和数据准备工作,模型训练完成后,对该特定领域的理解能力会增强。

- 向量嵌入(Embeddings): 这种方法不直接修改大模型本身。其核心思想是将企业的私有数据文档(如产品手册、知识库文章等)转化为计算机易于处理的数值向量(Embedding),存储在向量数据库中。当用户提问时,也将用户问题转化为向量,然后通过向量相似度搜索,快速找出与问题语义上最相关的文档片段。最后,将这些检索到的相关片段与用户问题一同作为上下文输入给大模型,让大模型基于这些“参考资料”来生成回答。这种方式适用于数据量巨大、内容更新频繁的场景,因为它无需反复训练模型,只需维护和更新向量数据库即可,更加灵活高效。

我们可以用一个更生动的比喻来理解这两种方法。想象一下,大型模型就像一位非常博学多才、能说会道的家庭助理,她懂得很多常识,也能处理各种问题,但她对你“家”里(即你的企业私有数据)的具体情况并不了解。

- 微调就像是你在她正式上岗前,花时间给她进行一次系统的、针对你家的“岗前培训”,详细讲解家里的布局、重要物品的位置、特殊规定等,让她对你家形成一种更深刻、更“内化”的理解。

- 向量嵌入则更像是你在家里的关键位置贴上详细的“操作指南”或“参考手册”。当她需要处理某个具体任务(例如,回答用户关于某款产品的问题)时,她会先去查阅与这个问题相关的指南,然后结合自己的知识和这些指南来给出最准确的回答。

综合考量私有数据量、更新频率以及实现灵活性后,许多构建专属ai智能客服的方案倾向于采用基于Embeddings的方法。通过在每次对话中,智能地检索并提供相关的私有数据片段作为上下文,并结合预设的Prompt(如设定客服角色、回答风格等),成功突破了Token限制的难题,使得大模型能够针对性地回答基于企业私有数据的专业问题。

Embeddings模型与私有数据的高效整合策略

那么,基于Embeddings构建专属ai智能客服的具体技术思路是怎样的呢?其核心在于如何高效地将企业的非结构化私有数据(如各类文档)转化为可供大模型利用的结构化信息。向量嵌入(Embeddings)技术在此扮演了关键角色。它能够将文本、图片、音频等非结构化数据,抽象转化为高维度的数值向量。这些向量在多维空间中承载了原始数据的语义信息,相似的数据点在向量空间中的距离也更近。

基于这一原理,构建流程通常包含以下几个关键步骤:

1)数据预处理与向量化: 首先,需要收集企业的所有私有文档资料,包括但不限于PDF格式的产品手册、Word格式的技术文档、TXT格式的常见问题集、Markdown格式的内部知识分享等。这些文档需要经过处理,通常是切分成大小适中、具有独立语义的文本块或片段。接着,利用成熟的Embedding模型(如OpenAI提供的Ada模型或其他先进的开源/商业模型),将每一个文本片段转化为一个高维向量。这些向量随后被存储在一个专门设计用于高效相似度检索的向量数据库中。

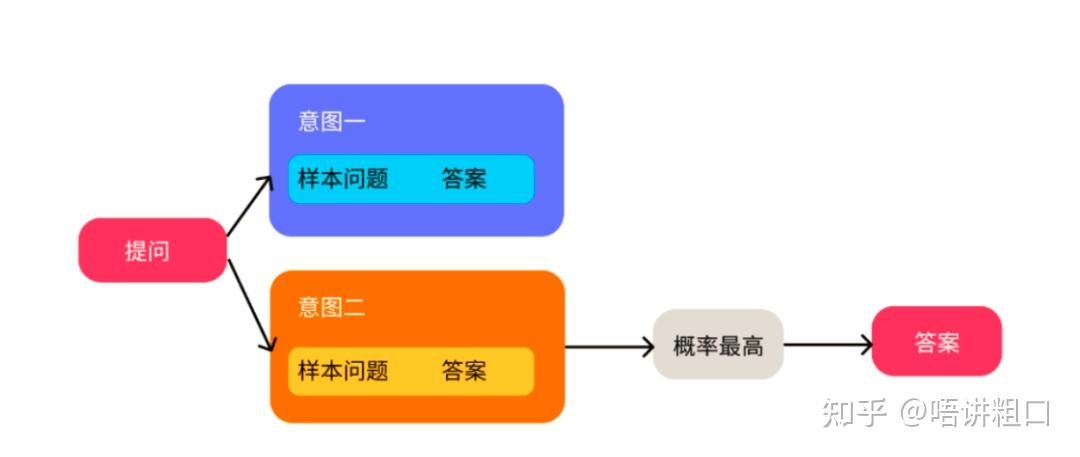

2)用户查询向量化与语义检索: 当用户在客服界面提出一个问题时,同样使用第一步中相同的Embedding模型,将用户的自然语言问题转化为一个查询向量。随后,这个查询向量被用于在向量数据库中执行一次相似度搜索。通过计算用户查询向量与数据库中所有私有数据向量之间的相似度(常用的算法是余弦相似度),系统能够快速、准确地找出在语义上与用户问题最相关的若干个文本片段。与传统的基于关键词的搜索不同,语义相似性搜索即使问题中不包含文档原文的关键词,只要表达的意思相关,也能被有效地检索出来(例如,搜索“汽车加油”也能找到关于“车辆能源补给”或“汽油种类”的相关文档)。

3)结合上下文生成回答: 最后一步是将用户原始的问题,以及从向量数据库中检索到的与问题最相关的文本片段,一同打包构建成一个包含了丰富上下文信息的Prompt。这个Prompt被发送给大型语言模型(如GPT系列)。在构建Prompt时,还可以进一步指定AI客服的角色(例如“你是一位专业的[公司名称]产品顾问”)、期望的回答风格(友好、专业、简洁)以及回答要求(必须基于提供的资料回答,如果资料中没有信息则回复“不知道”)。大模型接收到这些信息后,便能够依据提供的私有数据上下文,结合自身强大的语言理解和生成能力,产生一个既准确、专业,又贴合企业实际情况的自然语言回答。

相较于传统的问答机器人通常依赖于人工构建复杂的规则集或知识图谱,这种基于大型模型和Embeddings的方法极大地简化了知识库的构建和维护工作。企业不再需要耗费巨大精力进行大量的语料标注、意图分类和规则设定,只需将原始文档数据进行适当处理和向量化即可。通过这种方式,大型模型的强大语言理解和生成能力得以充分发挥,结合企业私有数据的精准性和时效性(通过向量数据库的实时更新实现),最终实现了更加智能、自然、且高度定制化的AI客服体验,显著提升了客户满意度和运营效率。

总结:

总而言之,利用大型语言模型(如GPT)结合向量嵌入(Embeddings)技术,是当前构建高效、精准、基于企业私有数据的高级ai智能客服的主流且有效方案。这种方案通过智能检索相关文档片段作为大模型的上下文,不仅成功突破了大型模型自身的Token限制,解决了在特定领域提供精准专业问答的难题,还大幅降低了传统客服机器人对人工知识整理和维护的依赖。这为企业提供了更智能、更高效、更贴合业务需求的客户服务解决方案,从而解放了人工客服的精力去处理更复杂、更具价值的任务,真正开启了专属智能客服的新篇章。